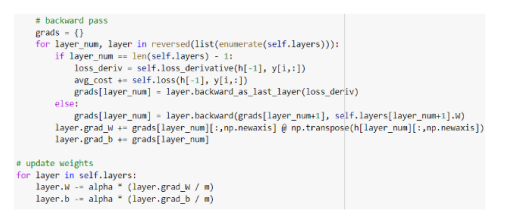

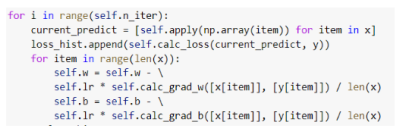

Ранее мы уже использовали подобие SGD — обновляли веса после каждого сэмпла, но мы об этом вам не говорили. Сопоставьте примеры кода и оптимизаторы:

Другие предметы Университет Оптимизация в машинном обучении анализ данных университете SGD обновление весов примеры кода оптимизаторы машинное обучение обучение модели алгоритмы оптимизации статистический анализ

Давайте разберемся с оптимизаторами и их реализациями в коде. В данном случае мы будем рассматривать стохастический градиентный спуск (SGD) и его вариации. Вот основные шаги, которые помогут вам сопоставить примеры кода с оптимизаторами:

-

Определите тип оптимизатора:

- SGD (Стохастический градиентный спуск)

- Mini-batch SGD (Мини-пакетный SGD)

- Adam (Адаптивный моментный градиентный спуск)

- RMSProp (Корректировка среднеквадратичного градиента)

-

Посмотрите на обновление весов:

- Если веса обновляются после каждого сэмпла, то это, скорее всего, SGD.

- Если обновление происходит после обработки мини-пакета (например, 32 или 64 образца), то это Mini-batch SGD.

- Если вы видите использование адаптивных параметров, таких как моментум или различные скорости обучения для каждого веса, то это может быть Adam или RMSProp.

-

Проверьте параметры оптимизатора:

- SGD обычно имеет параметры, такие как скорость обучения и моментум.

- Adam включает в себя параметры для начальной скорости обучения, а также параметры для корректировки моментов.

- RMSProp также использует параметры для сглаживания градиентов.

-

Сравните примеры кода:

- Обратите внимание на синтаксис и функции, используемые для инициализации и обновления весов.

- Посмотрите, как реализованы циклы обучения и как обрабатываются данные.

Теперь, когда вы понимаете, как сопоставлять примеры кода с оптимизаторами, вы сможете более эффективно выбирать подходящий метод для своих задач. Если у вас есть конкретные примеры кода, мы можем разобрать их вместе!